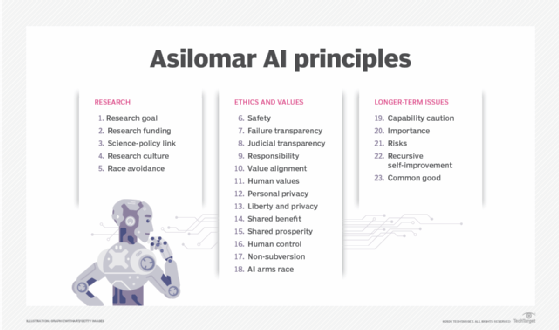

Princípios da IA de Asilomar são 23 diretrizes para a pesquisa e desenvolvimento da inteligência artificial (IA). Os princípios de Asilomar esboçam questões de desenvolvimento de IA, ética e diretrizes para o desenvolvimento de IA benéfica e para facilitar o desenvolvimento de IA benéfica. Os princípios foram criados na Conferência de Asilomar sobre IA benéfica em 2017 em Pacific Grove, Califórnia. A conferência foi organizada pelo Future of Life Institute.

The Future of Life Institute é uma organização sem fins lucrativos cuja missão é "catalisar e apoiar pesquisas e iniciativas para salvaguardar a vida e desenvolver visões otimistas do futuro, incluindo formas positivas para a humanidade conduzir seu próprio curso considerando novas tecnologias e desafios". A organização foi fundada em 2014 pelo cosmólogo do MIT Max Tegmark, o co-fundador da Skype Jaan Tallinn, o físico Anthony Aguirre, Viktoriya Krakovna e Meia Chita-Tegmark. A partir deste escrito, 1.273 pesquisadores de inteligência artificial e robótica assinaram os princípios, bem como com 2.541 outros endossadores de uma variedade de indústrias.

Muitas vezes, os princípios são uma declaração clara de possíveis resultados indesejáveis, seguidos por uma recomendação para evitar tal evento. Por exemplo, sob a categoria ética e valores, a principal corrida armamentista AI declara que uma corrida armamentista em armas autônomas letais deve ser evitada.

Os Princípios AI de Asilomar são subdivididos em 3 categorias: Pesquisa, Ética e Valores e Questões de Longo Prazo.

Pesquisa<

- Pesquisa - O objetivo da pesquisa da IA deve ser criar não inteligência indireta, mas inteligência benéfica.

- Financiamento da pesquisa - Os investimentos em IA devem ser acompanhados de financiamento para pesquisa que garanta seu uso benéfico.

- Li>Ligação ciência-política - Deve haver um intercâmbio construtivo e saudável entre pesquisadores de IA e formuladores de políticas.cultura de cooperação, confiança e transparência deve ser promovida entre pesquisadores e desenvolvedores de IA.

- Evite de corridas - Equipes desenvolvendo sistemas de IA devem cooperar ativamente para evitar cortes nas normas de segurança.

> forte>Ethics and Values

- Safety - Os sistemas de IA devem ser seguros e protegidos durante toda a sua vida operacional, e verificável quando aplicável e viável.

- Failure transparency - Se um sistema de IA causa danos, deve ser possível verificar o porquê.

- Transparência judicial - Qualquer envolvimento de um sistema autônomo na tomada de decisões judiciais deve fornecer uma explicação satisfatória e auditável por uma autoridade humana competente.

- Responsabilidade - Designers e construtores de sistemas avançados de IA são partes interessadas nas implicações morais de seu uso, mau uso e ações, com responsabilidade e oportunidade de moldar essas implicações.

- Alinhamento de valores - Sistemas de IA altamente autônomos devem ser projetados para que seus objetivos e comportamentos possam ser alinhados com os valores humanos ao longo de sua operação.

- Valores humanos - Sistemas de IA devem ser projetados e operados de forma a serem compatíveis com ideais de dignidade humana, direitos, liberdades e diversidade cultural.

- Privacidade pessoal - As pessoas devem ter o direito de acessar, gerenciar e controlar os dados que geram, dado o poder dos sistemas de IA para analisar e utilizar esses dados.

- Liberdade e privacidade - A aplicação de IA aos dados pessoais não deve restringir irrazoavelmente a liberdade real ou percebida das pessoas.

- Benefício compartilhado - As tecnologias de IA devem beneficiar e capacitar o maior número possível de pessoas.

- Persperidade compartilhada - A prosperidade econômica criada pela IA deve ser compartilhada amplamente, para beneficiar toda a humanidade.

- Controle humano - Os humanos devem escolher como e se delegar decisões aos sistemas de IA, para alcançar os objetivos escolhidos pelo homem.

- Não-subversão - O poder conferido pelo controle de sistemas de IA altamente avançados deve respeitar e melhorar, ao invés de subverter, os processos sociais e cívicos dos quais depende a saúde da sociedade.

- Uma corrida armamentista AI - Uma corrida armamentista em armas autônomas letais deve ser evitada.

> forte> Questões de longo prazo /p>

- Cautela na capacidade - A menos que haja consenso, evite fortes suposições sobre os limites superiores das capacidades futuras de IA.

- Importância - A IA avançada pode representar uma mudança profunda na história da vida na Terra, e deve ser planejada e gerenciada com cuidados e recursos proporcionais.

- Riscos - Os riscos colocados pelos sistemas de IA, especialmente riscos catastróficos ou existenciais, devem ser sujeitos a esforços de planejamento e mitigação proporcionais ao seu impacto esperado.

- Auto-melhoramento recursivo - Sistemas de IA projetados para se auto-aperfeiçoar ou se auto-replicar de forma que possa levar a um rápido aumento de qualidade ou quantidade devem estar sujeitos a medidas rigorosas de segurança e controle.

- Bom comum - Superinteligência deve ser desenvolvida apenas a serviço de ideais éticos amplamente compartilhados, e para o benefício de toda a humanidade e não de um estado ou organização.